Un tema que sin duda causa revuelo y opiniones encontradas es cuando los congresos se apalancan en revistas de reconocida trayectoria para fomentar la participación de investigadores, ergo aumentar sus matriculaciones. Algo que para unos es una simple estrategia de marketing, para otros es una contradicción a la ética de las publicaciones, pues el darle prioridad de acceso a ciertos trabajos, a expensas de la reducción de espacios para otros no vinculados con el evento, puede tener ciertas connotaciones negativas.

Sin embargo, este tipo de acciones no es algo de nueva data o contra natura, ni mucho menos. De hecho, es algo muy común en la comunidad académica internacional, sobre todo en asociaciones y redes que han creado en su seno reuniones anuales, congresos, revistas científicas, anuarios y hasta call for chapters de libros científicos. Por ejemplo, el Instituto de Ingenieros Eléctricos y Electrónicos [Institute of Electrical and Electronics Engineers] (IEEE) cuenta con más de 1600 congresos -muchos con proceedings en Scopus®-, 400.000 miembros, 340 secciones locales, y más de 6000 publicaciones indexadas. En este caso resulta muy normal que dentro de los congresos, además de los proceedings y research in progress, se pongan a disposición algunos monográficos o special issues ad hoc.

Otro caso muy común es el de las asociaciones internacionales de Comunicación (como ICA, IAMCR, ECREA, o ICORIA), que cuentan con congresos anuales organizados por secciones estables y grupos de trabajo temporales que promueven, a lo interno del evento, alguna serie específica de libros para hacer obras colectivas, o números especiales dentro de sus revistas asociadas.

Sin embargo, en los casos revisados es infrecuente evidenciar que se mezclen las revistas con las comunicaciones aprobadas, sino que lo más habitual es que en el marco de la preparación del evento por parte de las secciones estables y grupos de trabajo (muy especializados sobre una temática específica dentro de la rama o área del conocimiento del evento), sean los coordinadores de estos los que propongan una serie de outputs de la reunión, como por ejemplo algún monográfico en una revista, un call for chapters, o una serie de webinars para la difusión de las investigaciones.

¿Participar como revista de un congreso? Sí, pero con cautela

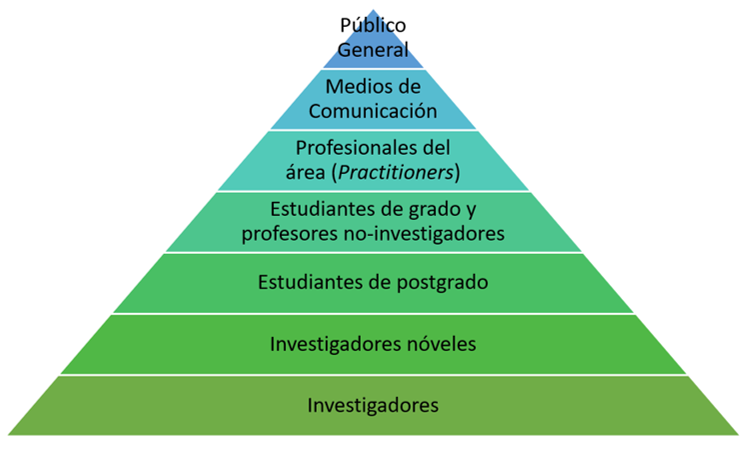

El que una publicación científica colabore con un congreso de su área del conocimiento es, a priori, algo positivo. No olvidemos que este tipo de reuniones es un espacio natural de interacción de la comunidad científica, lo que coadyuva a la visibilidad y consolidación de la revista en el colectivo de investigadores (su público objetivo por antonomasia), pero además garantiza que se reciban más trabajos -y por ende, haya más capacidad de selección-, algo que muchas revistas, sobre todo las emergentes, necesitan.

Pero hay que tener cuidado de no caer en la trampa de que la revista se convierta en un anzuelo dentro del entramado del consumer journey de un evento científico. Para evitar posibles confusiones, os recomendamos tener en cuenta:

- La decisión editorial de crear un special issue para un evento científico debe sustentarse en que este esté avalado por instituciones, centros y asociaciones de reconocida trayectoria, cuyos organizadores sean investigadores consolidados en el ámbito del conocimiento, y que el evento tenga un comité científico de primer nivel.

- Debe advertirse que todos los artículos que se reciban por parte de los organizadores del evento pasarán, indefectiblemente, por revisión editorial y por pares. Esto debe quedar meridianamente claro en la normativa de la revista, pero también en la web del evento y sus espacios promocionales.

- Debe solicitarse a los organizadores que expresamente en la web y la promoción del evento científico se explique que la selección primaria de los artículos la harán los responsables del congreso o de los grupos de trabajo. De esta manera, la responsabilidad del primer cribado será exclusivamente de los organizadores.

- En los congresos de mayor tamaño se deben pautar previamente entre el cuerpo editor y los organizadores el mínimo y máximo de artículos a recibir, la temática y los enfoques prioritarios del call for papers, así como la forma en la que se procederá al envío de los artículos (por ejemplo, por el OJS de la revista).

- Los coordinadores del monográfico o special issue del evento deben ser investigadores de reconocida trayectoria científica. Además, debe intentarse que sean de colectivos distintos -geográficos, asociativos, y de grupos de trabajo- para evitar que puedan existir sesgos a la hora de hacer recomendaciones editoriales.

- La revista debe hacer el esfuerzo de escoger pares revisores que no hayan participado en el mismo evento. Si son revisores externos a ese contexto geográfico y asociativo, se garantizará mayor imparcialidad y objetividad en las decisiones arbitrales.

- Al igual que todos los artículos, los que lleguen por el congreso deberán pasar por el control antiplagio. Sin embargo, debe quedarles meridianamente claro, tanto a los organizadores del evento, como a los autores, que las comunicaciones que pasen a la revista no pueden publicarse, ni total ni parcialmente, en libros de actas u obras colectivas. Esto se advierte porque muchas veces estas obras editoriales se publican en papel, lo que hace imposible detectar similaridades por los softwares antiplagio.